Wprowadzenie

Dużą popularność zdobywają aplikacje, wykorzystujące modele uczenia maszynowego do generowania obrazów. Nie jest to jednak ich jedyne zastosowanie. Dostępnych jest wiele modeli, często wyspecjalizowanych, które umożliwiają pracę z już istniejącymi obrazami. W takich przypadkach nowa treść wizualna jest generowana poprzez przetwarzanie oryginalnego obrazu, czasem w bardzo precyzyjnych granicach i ograniczonym zakresie.

Niniejsze opracowanie przedstawia podstawowe typu maszynowej modyfikacji obrazów z wykorzystaniem tego typu modeli. Ich jakość ograniczona jest m.in. limitami zasobów obliczeniowych Hugging Face oraz efektywnością poszczególnych modeli.

Część merytoryczna

Aby samodzielnie testować podane tu przykłady, warto założyć darmowe konto na platformie Hugging Face. Platforma ta gromadzi modele, dane treningowe oraz przestrzenie (spaces), które umożliwiają testowanie efektywności modeli przetwarzania obrazu.

Przestrzenie na Hugging Face to nic innego jak aplikacje testowe, które pokazują w działaniu wybrane modele i techniki uczenia maszynowego. Celem takich wersji demo jest prezentacja modeli na konferencjach naukowych, w dydaktyce czy negocjacjach z inwestorami. W wielu przestrzeniach Hugging Face znajdziemy też bezpośrednie cytowania tekstów naukowych, które dokładnie opisują zasady działania konkretnego modelu.

Przestrzenie Hugging Face dostępne są w przeglądarce, ale możemy korzystać z nich także na własnym komputerze (wymaga to jednak przygotowania odpowiedniego środowiska programistycznego i konfiguracji aplikacji).

Outpainting

Outpainting to technika przetwarzania obrazów za pomocą modeli uczenia maszynowego, która pozwala na rozszerzanie treści obrazu poza jego oryginalne granice. Generowane dodatkowe obszary obrazu zachowują spójność stylu i nawiązują do szczegółów i elementów, które są widoczne na źródłowym obrazie. Outpainting wykorzystuje się do poszerzania scen, rozwijania tła i umieszczania w obrazie dodatkowych detali, które bezpośrednio wynikają z jego pierwotnej treści.

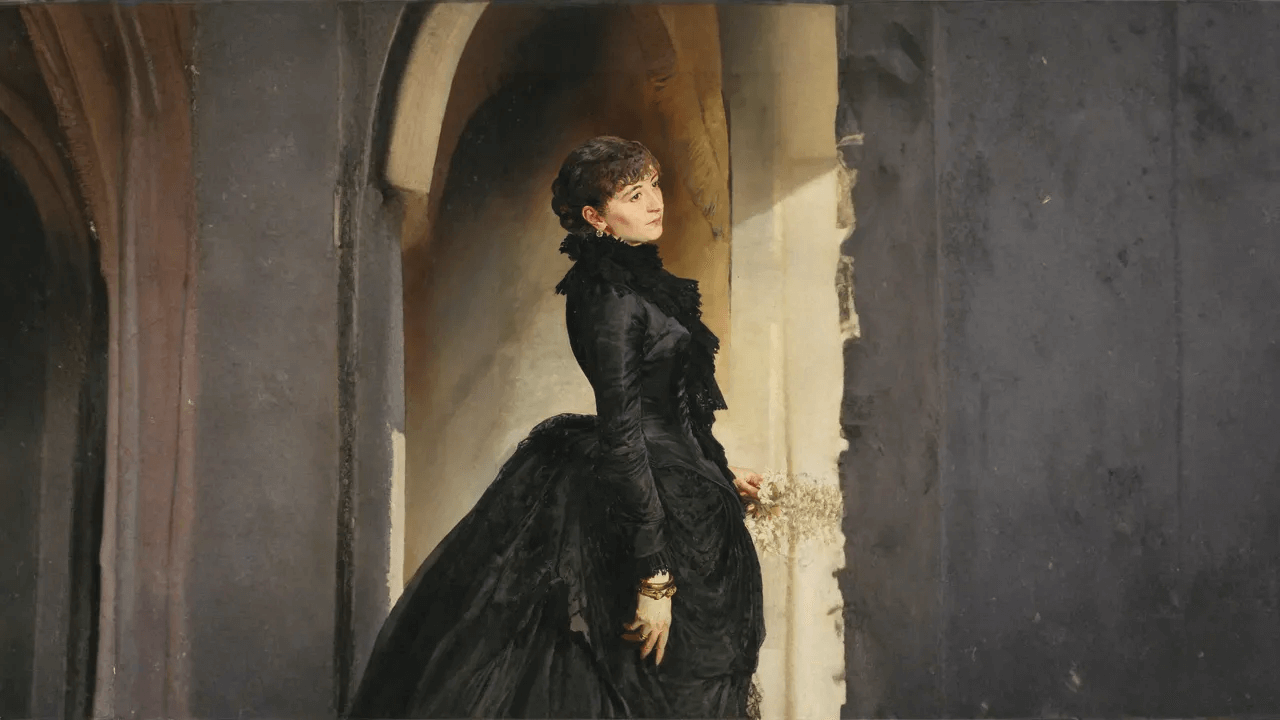

Jacek Malczewski, Portret Stefanii Dobrzańskiej (1882), Muzeum Narodowe we Wrocławiu

Jacek Malczewski, Portret Stefanii Dobrzańskiej (1882), Muzeum Narodowe we Wrocławiu  Obraz przetworzony z wykorzystaniem przestrzeni ffiloni/diffusers-image-outpaint

Obraz przetworzony z wykorzystaniem przestrzeni ffiloni/diffusers-image-outpaint Inpainting z wykorzystaniem promptów

Inpainting to technika przetwarzania obrazu, polegająca na edytowaniu lub uzupełnianiu brakujących bądź niepożądanych fragmentów. Modele wykorzystywane w aplikacjach tego typu analizują kontekst (otoczenie) usuwanych lub zmienianych elementów i generują brakujące treści tak, żeby wpasowały się one w całość obrazu i respektowały jego styl. Inpainting wykorzystywać można do twórczej manipulacji obrazami, ale też np. do uzupełniania ubytków uszkodzonych fotografii.

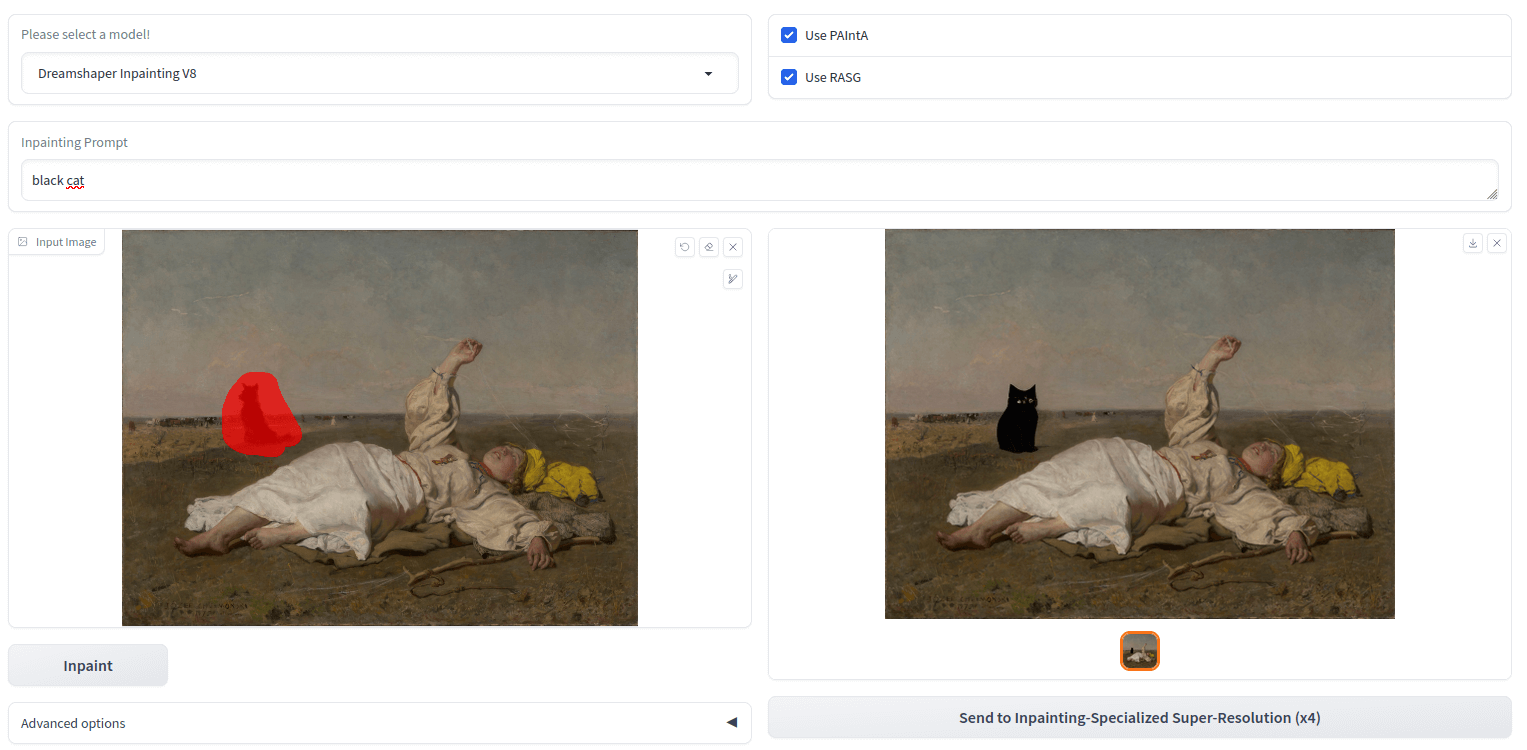

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie Przestrzeń obrazu do podmiany zaznaczamy za pomocą pędzla, po czym podajemy tekst promptu, który wygeneruje oczekiwany obiekt w zaznaczonym miejscu:

Inpainting: usuwanie obiektów

Z pomocą technik inpaintingowych możemy nie tylko dodawać obiekty do obrazu, ale też je z niego usuwać. Dzięki temu możliwe jest retuszowanie zdjęć, poprawianie kompozycji oraz eliminowanie wybranych elementów w sposób nieraz trudny do wykrycia.

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie  Obraz przetworzony z wykorzystaniem przestrzeni Sanster/Lama-Cleaner-lama

Obraz przetworzony z wykorzystaniem przestrzeni Sanster/Lama-Cleaner-lama Upscaling: powiększenie obrazu cyfrowego

Upscaling to proces zwiększania rozdzielczości obrazu przy jednoczesnym zachowaniu, a często nawet poprawie jego jakości. Tradycyjne metody skalowania mogą prowadzić do utraty szczegółów i rozmycia obrazu (pikselizacja). Jest to problem szczególnie istotny w wizerunkach, które standardowo dostępne są w niewielkich rozdzielczościach (np. w sztuce pixel art). Istnieje wiele algorytmów pozwalających na zwiększenie rozdzielczości obrazu, które nie korzystają z uczenia maszynowego, korzystać można jednak także z modeli takich jak GFPGAN, który jest szczególnie przystosowany do pracy z wizerunkami twarzy.

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online (500x284px)

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online (500x284px)  Zdjęcie przetworzone z wykorzystaniem przestrzeni Algoworks/Image_Face_Upscale_Restoration-GFPGAN_pub (2000x1136px)

Zdjęcie przetworzone z wykorzystaniem przestrzeni Algoworks/Image_Face_Upscale_Restoration-GFPGAN_pub (2000x1136px) Transfer obiektów, kolorów i stylów

Dzięki modelom przetwarzania obrazu możemy łączyć ze sobą elementy pochodzące z różnych źródeł, tworząc spójne kompozycje. Transfer obiektów polega na wyodrębnianiu wybranych elementów z jednego obrazu i automatycznym umieszczaniu ich w innym, przy zachowaniu spójności obrazu wynikowego. Transfer kolorów i stylów działa podobnie, przy czym zmieniane są cechy estetyczne obrazu przy zachowaniu jego treści.

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online (jako layout)

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online (jako layout)  Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie (jako style)

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie (jako style)  Zdjęcie przetworzone z wykorzystaniem przestrzeni modelscope/TransferAnything

Zdjęcie przetworzone z wykorzystaniem przestrzeni modelscope/TransferAnything Kolorowanie zdjęć

Maszynowe kolorowanie czarno-białych fotografii i kronik filmowych zyskało dużą popularność, chociaż historycy wyrażają na ten temat opinie krytyczne:

Jeśli chcemy zachęcić nowe pokolenie do zrozumienia tego, co oznaczała wojna – a to samo w sobie jest oczywiście słuszne – powinniśmy zachęcać je do oglądania filmów [historycznych] w takiej postaci, w jakiej zostały one wytworzone, i poprzez ten wysiłek zachęcać do doceniania ich za to, czym były i co współcześnie znaczyły. To właśnie wysiłek prowadzi do zrozumienia. Bez niego nie ma prawdziwej empatii, jest tylko fałszywa sentymentalność. Film, który wygląda jakby został nakręcony w zeszłym tygodniu, przynależy tylko do zeszłego tygodnia.

Warto zwrócić uwagę, że kolory fotografii zależą od wielu czynników i mogą być różne w zależności od wykorzystywanego sprzętu, papieru oraz techniki wywoływania czy druku. Cechy te mają niekiedy charakter historyczny. Niestety, modele koloryzujące są zazwyczaj generyczne i ahistoryczne, co oznacza, że nie mogą być używane jako metody rekonstrukcji.

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online  Zdjęcie przetworzone z wykorzystaniem przestrzeni nightfury/Colorizer_Models

Zdjęcie przetworzone z wykorzystaniem przestrzeni nightfury/Colorizer_Models Usuwanie tła

Maszynowe usuwanie tła może być użytecznym narzędziem przy tworzeniu kolaży, plakatów oraz materiałów do mediów społecznościowych czy na strony internetowe.

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online  Zdjęcie przetworzone z wykorzystaniem przestrzeni Xenova/remove-background-web

Zdjęcie przetworzone z wykorzystaniem przestrzeni Xenova/remove-background-web Użyty w powyższym przykładzie model BRIA Background Removal v1.4 został wytrenowany na ponad 12 tys. fotografii, zawierającym m.in. zdjęcia stockowe, wizerunki e-commerce, treści związane z grami oraz reklamy. Z powodzeniem jednak można stosować go do obrazów:

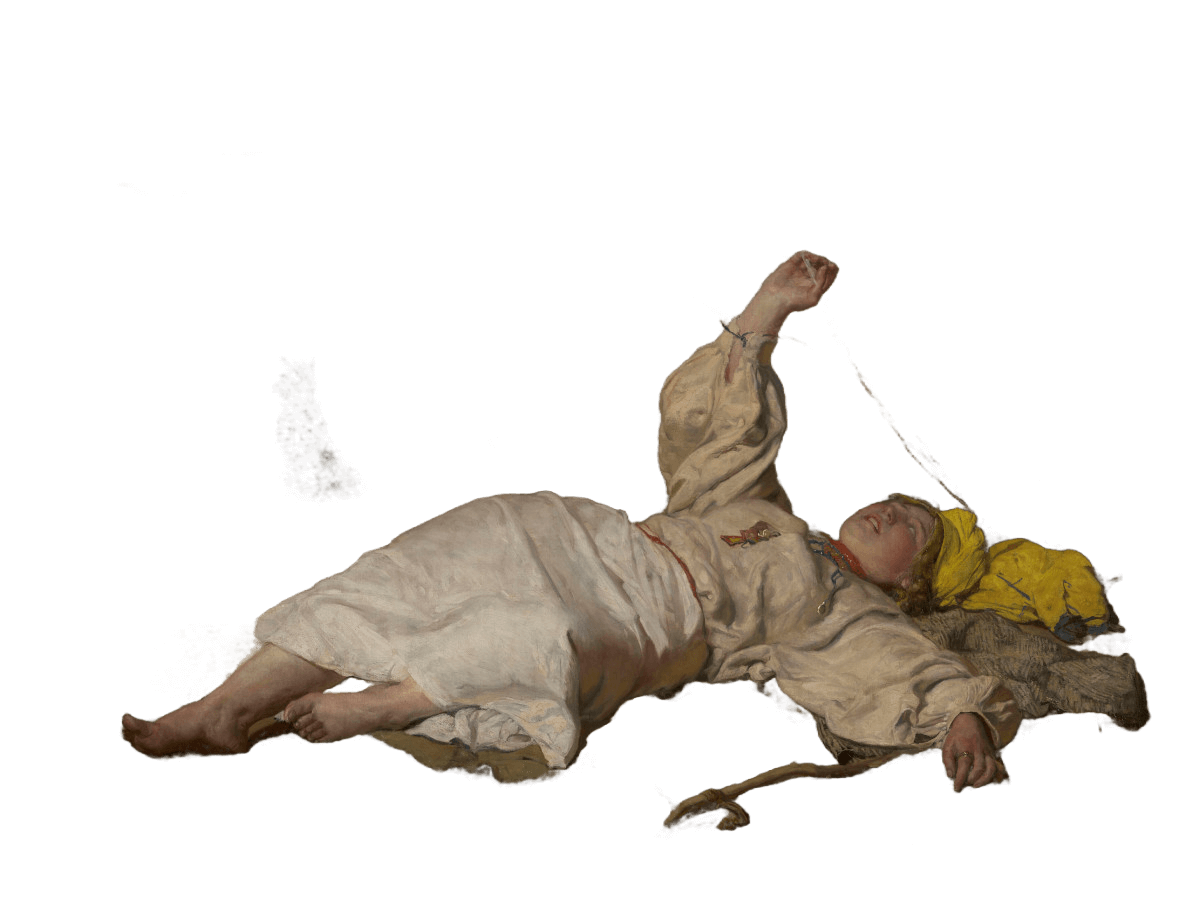

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie

Józef Chełmoński, Babie lato (1875), Muzeum Narodowe w Warszawie  Obraz przetworzony z wykorzystaniem przestrzeni Xenova/remove-background-web

Obraz przetworzony z wykorzystaniem przestrzeni Xenova/remove-background-web Edycja twarzy: face swap

Dzięki modelom tego typu możliwe jest precyzyjne przenoszenie rysów twarzy z jednej osoby na inną, zachowując przy tym naturalny wygląd, mimikę i spojność wynikowego obrazu.

Jacek Malczewski, Portret Stefanii Dobrzańskiej (fragment), Muzeum Narodowe we Wrocławiu

Jacek Malczewski, Portret Stefanii Dobrzańskiej (fragment), Muzeum Narodowe we Wrocławiu  Marcello Bacciarelli Portret Stanisława Lubomirskiego (1762), Muzeum Narodowe we Wrocławiu

Marcello Bacciarelli Portret Stanisława Lubomirskiego (1762), Muzeum Narodowe we Wrocławiu  Obraz przetworzony z wykorzystaniem przestrzeni felixrosberg/face-swap

Obraz przetworzony z wykorzystaniem przestrzeni felixrosberg/face-swap Manipulacje emocjami i wyrazem twarzy

Marcello Bacciarelli Portret Stanisława Lubomirskiego (1762), Muzeum Narodowe we Wrocławiu

Marcello Bacciarelli Portret Stanisława Lubomirskiego (1762), Muzeum Narodowe we Wrocławiu  Obraz przetworzony z wykorzystaniem przestrzeni jbilcke-hf/FacePoke

Obraz przetworzony z wykorzystaniem przestrzeni jbilcke-hf/FacePoke Maszynowe przetwarzanie wizerunków twarzy jest chyba jednym z najpopularniejszych zastosować modeli uczenia maszynowego - w ten sposób powstają prześmiewcze grafiki, memy, ale też materiały, które wytwarza się w celu manipulowania odbiorcami. W opracowaniu AI Hyperrealism: Why AI Faces Are Perceived as More Real Than Human Ones (2023) pokazano, że generowane maszynowo twarze osób o białym kolorze skóry mogą być nieodróżnialne od rzeczywistych twarzy takich osób (zjawisko hiperrealizmu):

W eksperymencie 1 (N = 124 dorosłych), wraz z ponowną analizą wcześniej opublikowanych danych, wykazaliśmy, że białe twarze generowane przez AI są częściej oceniane jako ludzkie niż rzeczywiste twarze ludzkie – zjawisko, które określamy mianem hiperrealizmu AI. Paradoksalnie, osoby popełniające najwięcej błędów w tym zadaniu były najbardziej pewne siebie (efekt Dunninga-Krugera). W eksperymencie 2 (N = 610 dorosłych) wykorzystaliśmy teorię przestrzeni twarzy (face-space theory) oraz jakościowe raporty uczestników, aby zidentyfikować kluczowe cechy twarzy, które odróżniają AI od twarzy ludzkich, ale były one błędnie interpretowane przez uczestników, co dowodziło hiperrealizmu AI.

Przetwarzanie statycznego obrazu do animacji

Efekt wykorzystania modelu AnimateLCM-SVD nie wydaje się specjalnie atrakcyjny. Jednak, jak czytamy w opracowaniu AnimateLCM: Computation-Efficient Personalized Style Video Generation without Personalized Video Data (2024), jego wartość polega na generowaniu animacji na jej dwóch niezbędnych warstwach. Oddziela się tu proces uczenia, którego efektem są kolejne klatki filmu (ruch) od powielania stylu źródłowego obrazu.

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online

Scena z Polskiej Kroniki Filmowej - PKF 51/17 (1951), wfdif.online Generowanie 3D

Automatyczne generowanie obiektów 3D na bazie dwuwymiarowych obrazów można wykorzystać przede wszystkim w edukacji, trudno spodziewać się przecież, że jakiekolwiek muzeum pozwoli sobie na prezentację obiektu 3D, którego cechy będą w dużej mierze halucynowane. W opisującym model TripoSR artykule (marzec 2024) czytamy, że rozwój modeli tego typu możliwy jest dzięki coraz większym publicznym zbiorom treningowym, zawierającym dobrej jakości obiekty 3D.

Wskazuje się też na problemy, jakie pojawiają się przy generowaniu 3D na podstawie wizerunków 2D czy nawet bezpośrednio z promptów - proces generowania trwa długo, wymaga też dużych zasobów obliczeniowych. Model TripoSR obiecuje szybkie przetwarzanie obrazu przy zachowywaniu jego szczegółów i został wytrenowany na zbiorze Objaverse.

Filiżanka do czekolady ze spodkiem i przykrywą (1735-1740) Muzeum Narodowe we Wrocławiu

Filiżanka do czekolady ze spodkiem i przykrywą (1735-1740) Muzeum Narodowe we Wrocławiu Warto spróbować także modelu SF3D, która dodatkowo pozwala na pracę ze światłem (ustawienie oświetlenia wyrenderowanego obiektu).

Podsumowanie

Platforma Hugging Face to świetne miejsce do samodzielnego testowania modeli uczenia maszynowego. Eksploracja tych modeli pozwala zobaczyć, jak bardzo są one zróżnicowane i sprofilowane. Wydaje się, że wartość rozwiązań sztucznej inteligencji opiera się przede wszystkim na realizacji zadań o określonym zakresie i określonym celu. Użyteczne w sektorze kultury, sztuki i dziedzictwa mogą więc być nie tyle ogólne modele (takie jak językowy GPT-3), ale specjalistyczne, trenowane na własnych zasobach instytucji i używane w ściśle określonych zadaniach.

Autentyczność zbiorów to fundamentalna wartość

Nie wydaje się też, żeby efekty przetwarzania obrazów, które widzieliśmy wyżej, miały szansę na wdrożenie w produkcji - raczej nie pojawią się nigdy w zbiorach muzeów cyfrowych czy w publikacjach. Wciąż korzystać musimy z profesjonalnych grafików i graficzek oraz pracowni czy firm zajmujących się skanowaniem. Maszynowe przetwarzanie obrazu wykorzystać możemy w edukacji (warsztaty) oraz do przygotowywania symulacji rozwiązań, które chcielibyśmy wdrożyć. Możemy również testować wybrane pomysły, np. zastanawiać się i badać, jaką wartość może dać naszym odbiorcom udostępnienie skanów 3D jeszcze przed podjęciem decyzji o ich profesjonalnym przygotowaniu.

Współczesna wartość instytucji kultury i dziedzictwa polega też na tym, że są w stanie - w świecie zalewanym generatywnymi treściami - gwarantować autentyczność poprzez oryginalne i dobrze opisane zbiory.

Uważajmy na slop

Generatywne obrazy są już powszechnie wykorzystywane w komunikacji w mediach społecznościowych. Warto jednak zastanowić się, czy takie treści, zamiast zachęcać odbiorców do interakcji z instytucją, z jakiegoś powodu ich do niej nie zniechęcają.Uważajmy na slop, niskiej jakości treści generatywne, które mogą naszym odbiorcom kojarzyć się negatywnie ze spamem i oszustwem, a używanie ich w komunikacji i promocji może być oceniane jako ślepe podążanie za trendami i przejaw lenistwa.

Nowe gatunki wypowiedzi wizualnych?

Czy szeroka dostępność narzędzi do generatywnego przetwarzania obrazów nie spowoduje, że wykształcą się zupełnie nowe gatunki wypowiedzi wizualnych? Techniki takie jak outpainting czy kolorowanie czarno-białych zdjęć proponują nowy sposób patrzenia na oryginalne obrazy i pozwalają na odkrywanie w nich nowych znaczeń, które - co ważne - mogą być zupełnie niezgodne z pierwotną intencją twórców i twórczyń.